【AWS re:Invent2022】Amazon EC2の新機能

2022.12.07

AWSが主催するクラウドコンピューティング最大のイベント「AWS re:Invent」が、2022年11月28日~12月2日にかけてアメリカのラスベガスにて開催されます。本ブログでは、AWS re:Inventに実際に参加したエンジニアから、イベントの様子やKeynote(基調講演)の現地レポートをいち早くお届けします。

今回は、11/30(火)15:15~16:15に開催されたAmazon EC2に関する講演をリポートします。

AWS re:Invent とは?

re:Inventとは、Amazon Web Services(以下、AWS)が主催するAWSに関するセッションや展示ブース、試験準備のためのブートキャンプやゲーム化された演習などを通じて、参加者が主体的に学習できるAWS最大のイベントです。

Amazon EC2 の新機能(CMP225)

セッション紹介を日本語訳すると、以下のような内容になります。

“ Amazon EC2 は、クラウドで安全でサイズ変更可能なコンピューティング キャパシティを提供し、Web スケールのコンピューティングを容易にします。

これは AWS の基本的なサービスであり、静的なウェブサイトからオンデマンドのスーパーコンピューティングまで、ほぼすべての考えられるユースケースに適したさまざまなコンピューティング インスタンスを提供し、柔軟な価格オプションで利用できます。

このセッションでは、機能、インスタンス ファミリー、ストレージとネットワーク機能、エッジとハイブリッドの提供に関する更新を含む、Amazon EC2 ポートフォリオの新機能の概要を説明します。 “

登壇者

登壇者はこちらの方々です。

| 会社名 | 登壇者 | 役職 |

|---|---|---|

| Amazon Web Services | Art Baudo | Principal Product Marketing Manager |

| Amazon Web Services | Martin Yip | Senior Manager, Product Marketing |

セッション会場の様子

MGM Grand(Grand 121)でのセッションとなっておりました。

新機能一覧

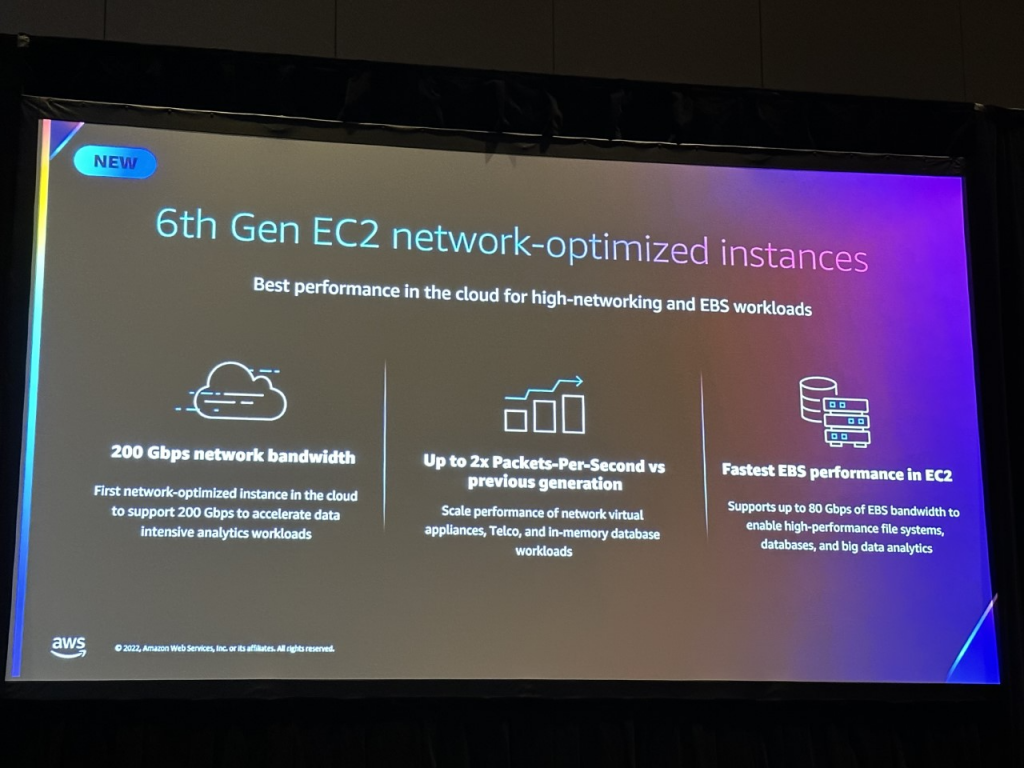

6th Gen EC2 network-optimized instances

ネットワーク負荷の高いEBSワークロードに対して、クラウド上でパフォーマンスを発揮します。

200 Gbpsのネットワーク帯域幅

200Gbpsをサポートするクラウド初のネットワーク最適化インスタンスにより、データ集約型の分析ワークロードを高速化

前世代と比較して最大2倍のパケットパーセカンドを実現

ネットワーク仮想アプライアンス、Telco、インメモリデータベースのワークロードのパフォーマンスをスケールアップ

EC2における最速のEBSパフォーマンス

最大80 GbpsのEBS帯域幅をサポートし、高性能なファイルシステム、データベース、およびビッグデータ分析を可能

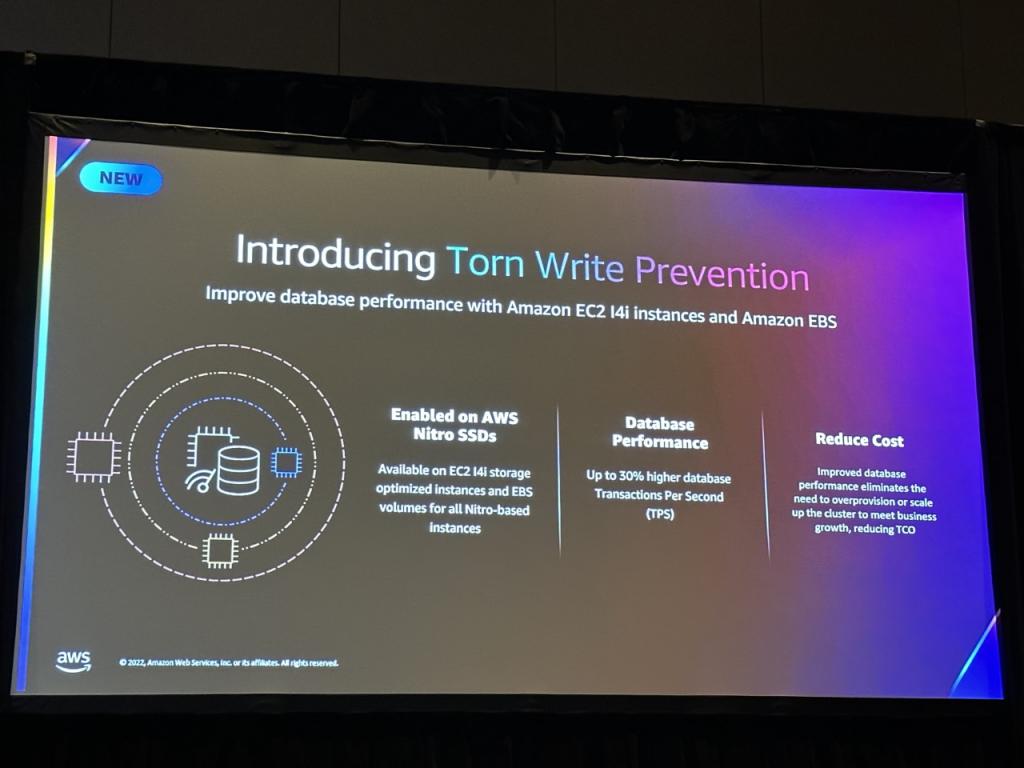

Introducing Torn Write Prevention

Amazon EC2 14iインスタンスとAmazon EBSでデータベースのパフォーマンスを向上させます。

AWS Nitro SSD

EC2 14iストレージ最適化インスタンス・全NitroベースインスタンスのEBSボリュームで利用可能

データベースパフォーマンス

最大30%向上したデータベース トランザクション/秒(TPS)

コスト削減

データベースパフォーマンスの向上により、ビジネスの成長に合わせてクラスタをオーバープロビジョニングまたはスケールアップする必要がなくなり、TCOが削減

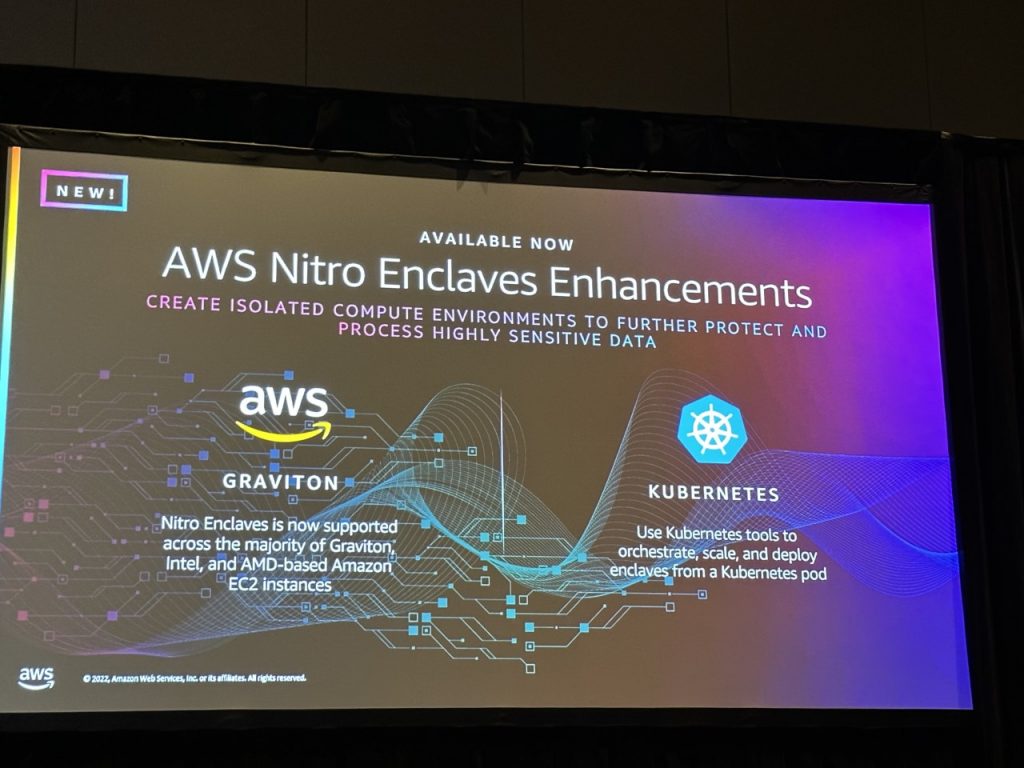

AWS Nitro Enclaves Enhancements

分離されたコンピュート環境を作成し、機密性の高いデータをさらに保護し処理することができます。

AWS GRAVITON

Nitro Enclavesは現在、Graviton、Intel、およびAMDがAmazon EC2インスタンスでサポート可能

KUBERNETES

Kubernetesツールを使用して、Kubernetesポッドからエンクレーブのオーケストレーション、スケール、およびデプロイを行う

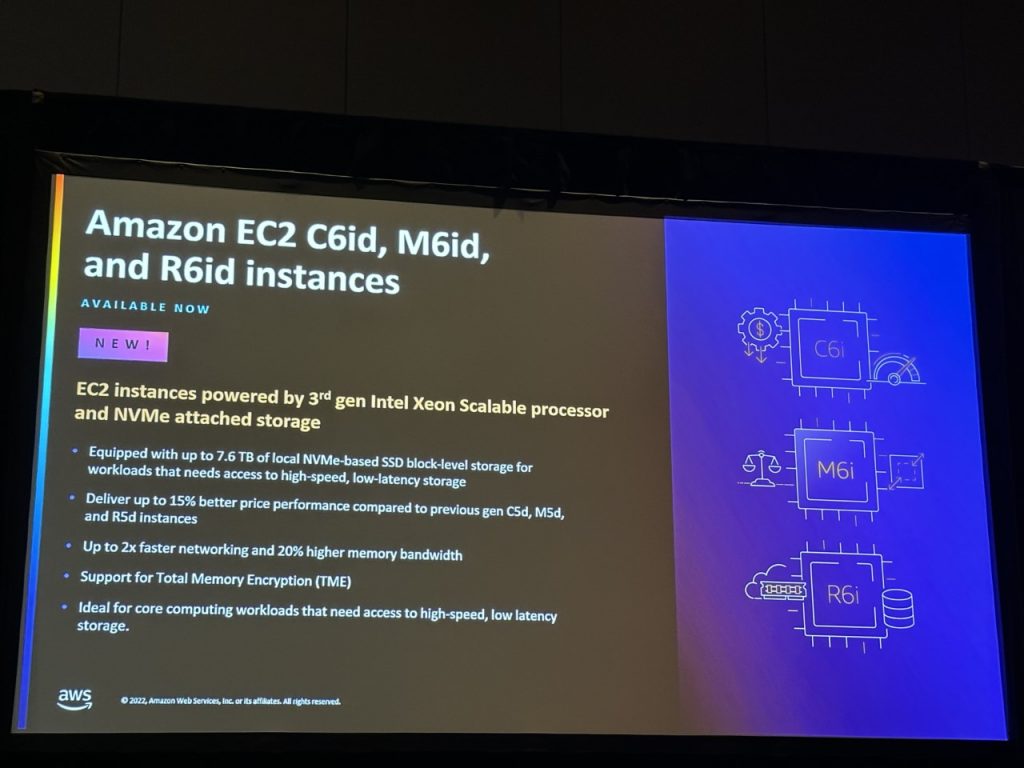

Amazon EC2 C6id, M6id, and R6id instances

第3世代Intel Xeon ScalableプロセッサーとNVMeアタッチドストレージを搭載したEC2インスタンスです。

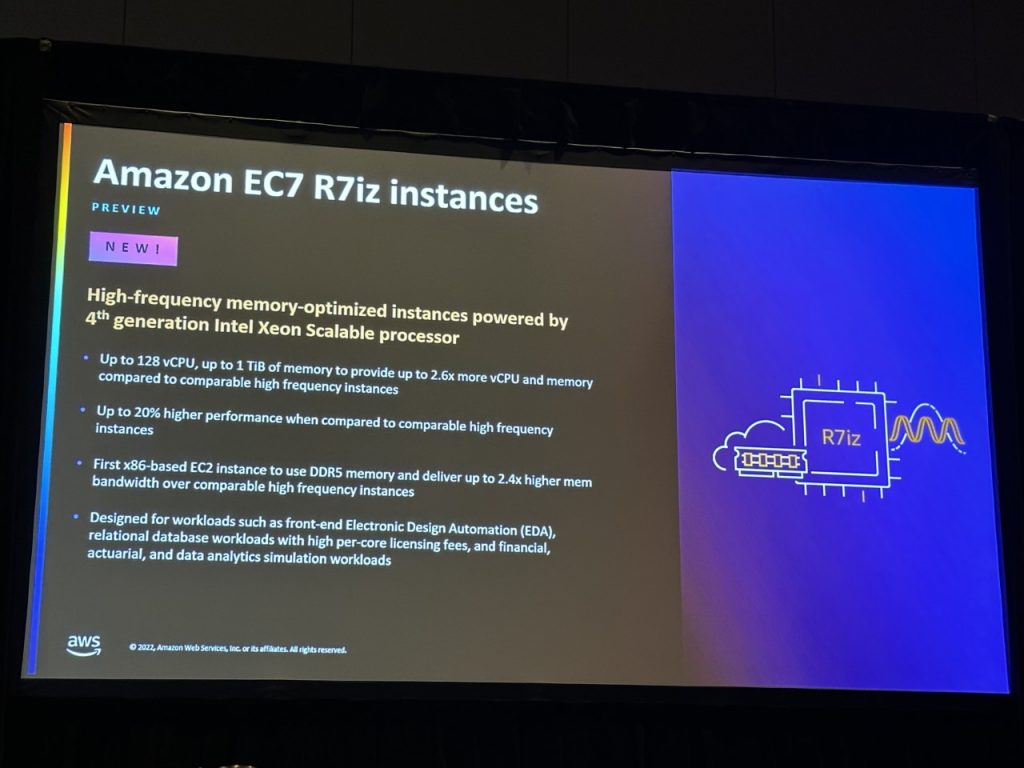

Amazon EC7 R7iz instances

第4世代インテル Xeon スケーラブルプロセッサ を搭載した 高速メモリ最適化インスタンスです。

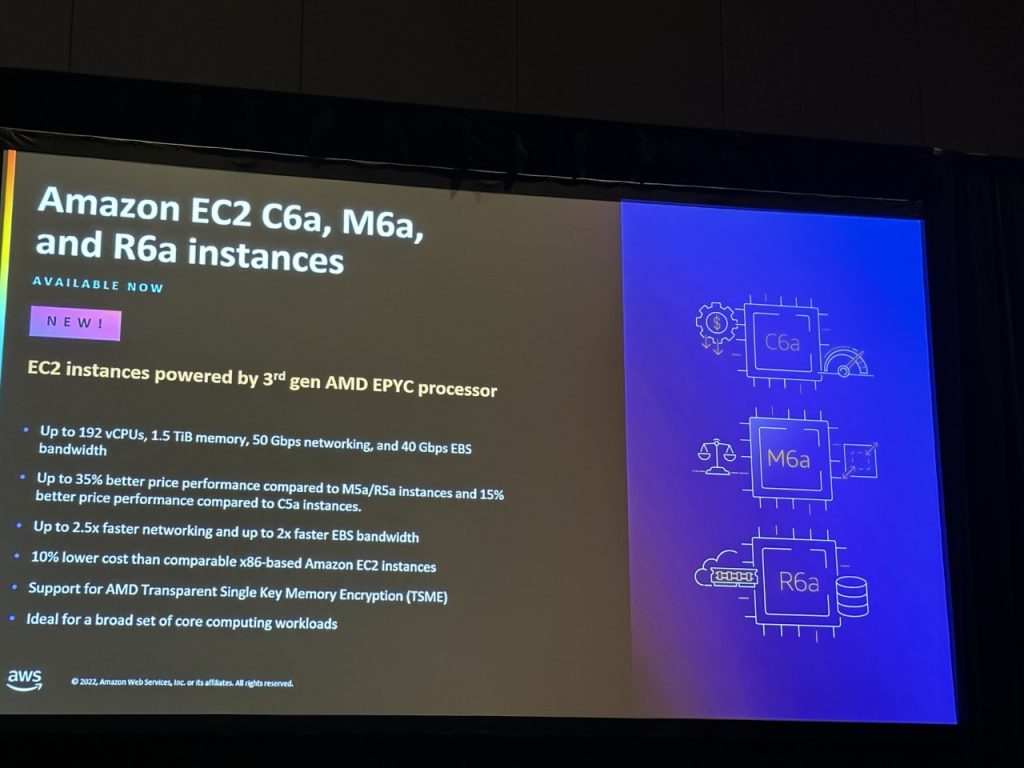

Amazon EC2 C6a, M6a, and R6a instances

第3世代AMD EPYCプロセッサを搭載したEC2インスタンスです。

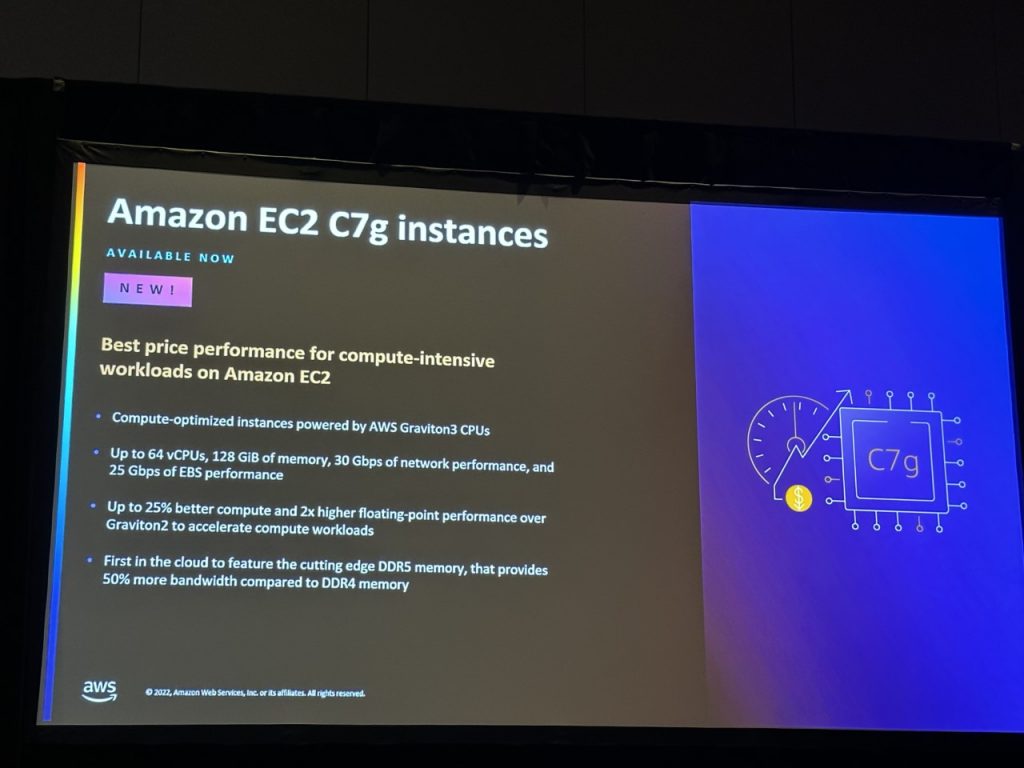

Amazon EC2 C7g instances

Amazon EC2における計算集約型ワークロードのためのベストプライス・パフォーマンスです。

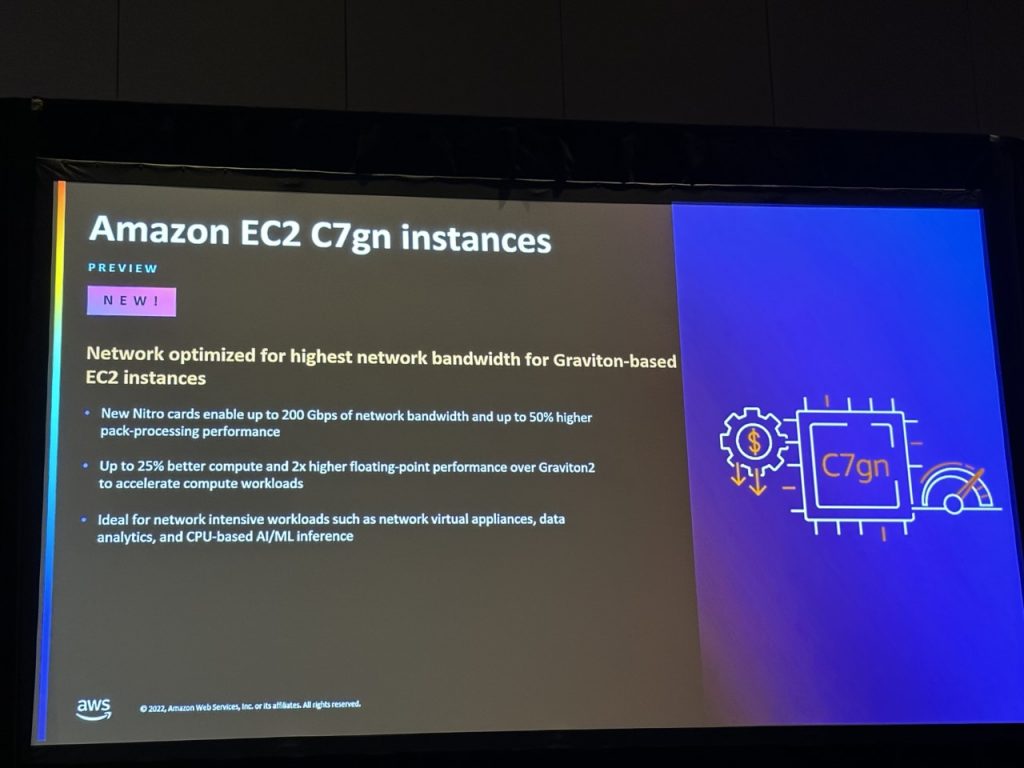

Amazon EC2 C7gn instances

Gravitonベースで最高のネットワーク帯域幅を実現するために最適化されたネットワーク EC2インスタンスです。

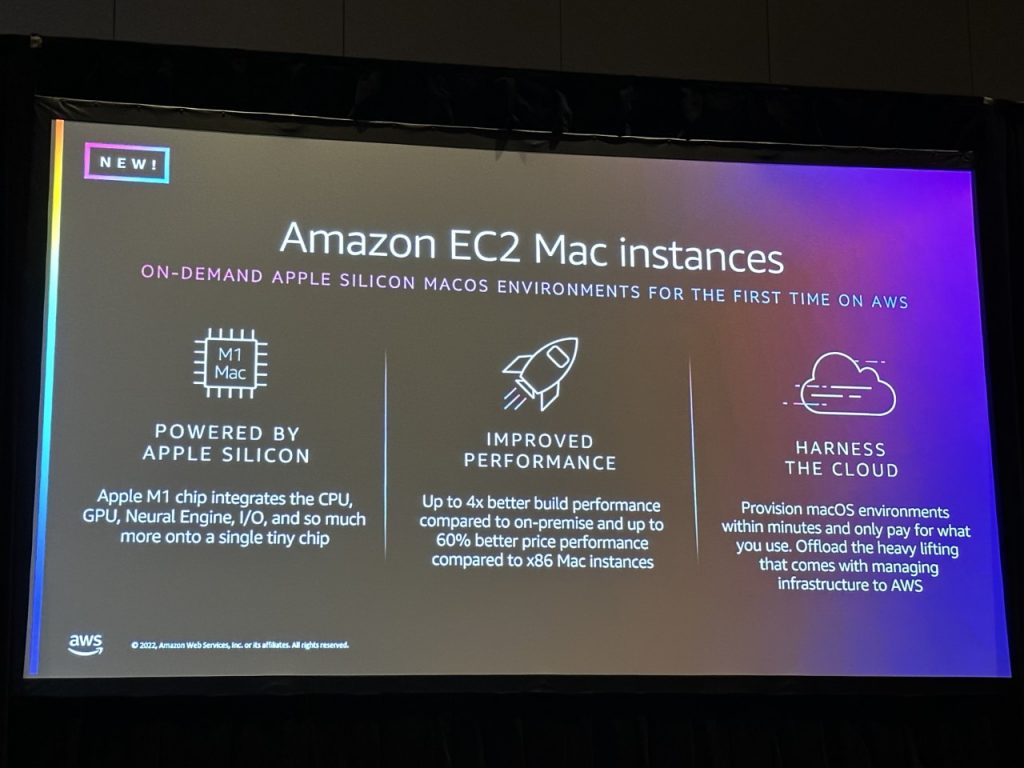

Amazon EC2 Mac instances

オンデマンドのAppleシリコンMacOSをAWSで初めて実現しました。

M1 Mac Apple シリコンを搭載

Apple M1チップは、CPU、GPU、Neural Engine、L/Oなどを1つの小さなチップに統合

パフォーマンスの向上

オンプレミスと比較して最大4倍の構築性能、x86 Macインスタンスと比較して最大60%の価格性能の向上

クラウドを活用

MacOS環境を数分でプロビジョニングし、使用した分だけを支払い、インフラストラクチャーの管理に伴う重労働をAWSにオフロード

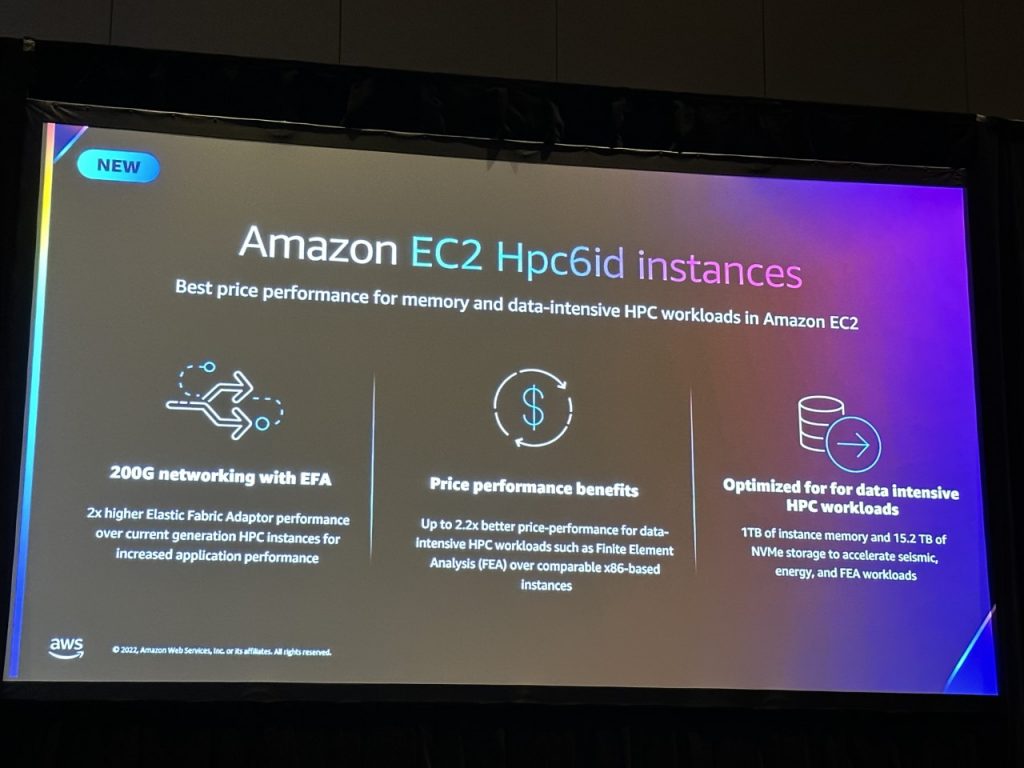

Amazon EC2 Hpc6id instances

Amazon EC2におけるメモリとデータ集約型HPCワークロードのためのベストプライス・パフォーマンスです。

EFAによる200Gネットワーキング

Elastic Fabric Adaptorのパフォーマンスが現世代のHPCインスタンスより2倍高く、アプリケーションのパフォーマンスを向上

価格性能のメリット

有限要素解析(FEA)などのデータ集約型HPCワークロードの価格性能は、同等の86ベースのインスタンスと比較して最大2.2倍優れているデータインテンシブHPCワークロードに最適化

1TBのインスタンスメモリと15.2TBのNVMeストレージにより、地震、エネルギー、およびFEAのワークロードを高速化

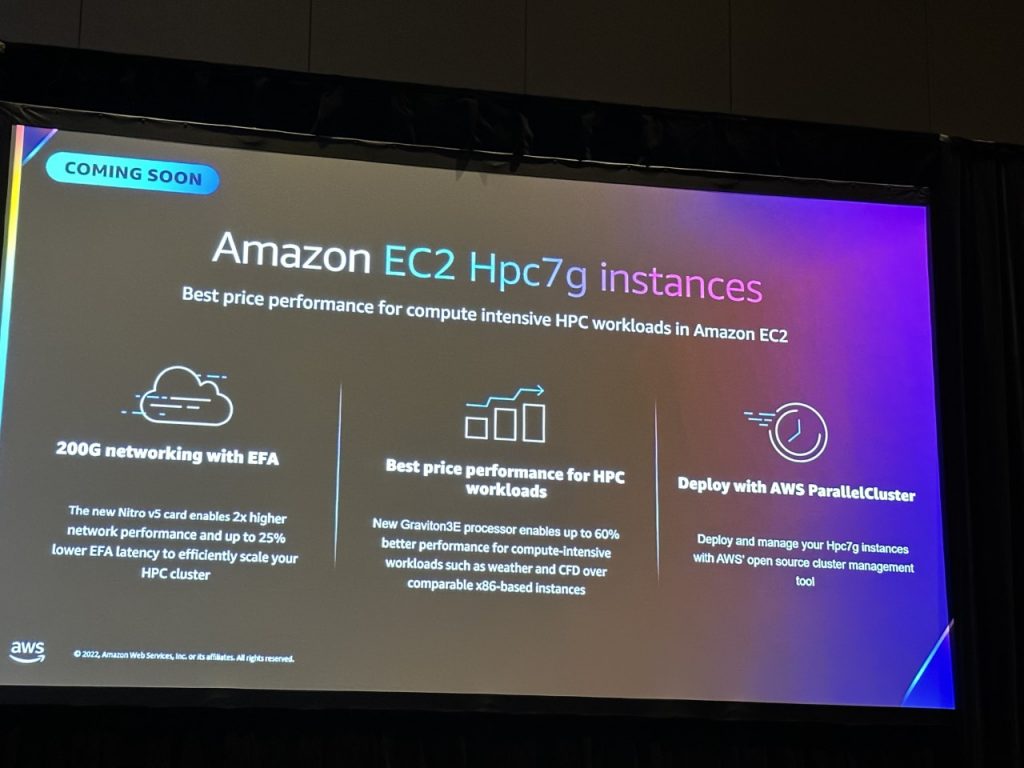

Amazon EC2 Hpc7g instances

Amazon EC2における計算集約型HPワークロードのためのベストプライス・パフォーマンス です。

EFA付き200Gネットワーキング

新しいNitro vSカードは、2倍高いネットワーク性能と最大25%低いEFAレイテンシーを実現し、HPCクラスターを効率的に拡張

HPCワークロードのための最適な価格性能

新しいGraviton3Eプロセッサにより、気象やCFDなどの計算集約型のワークロードにおいて、同等の86ベースのインスタンスと比較して最大60%の性能改善を実現

AWS ParallelClusterを用いた展開

AWSのオープンソースクラスター管理ツールでHpc7gインスタンスを導入・管理が可能

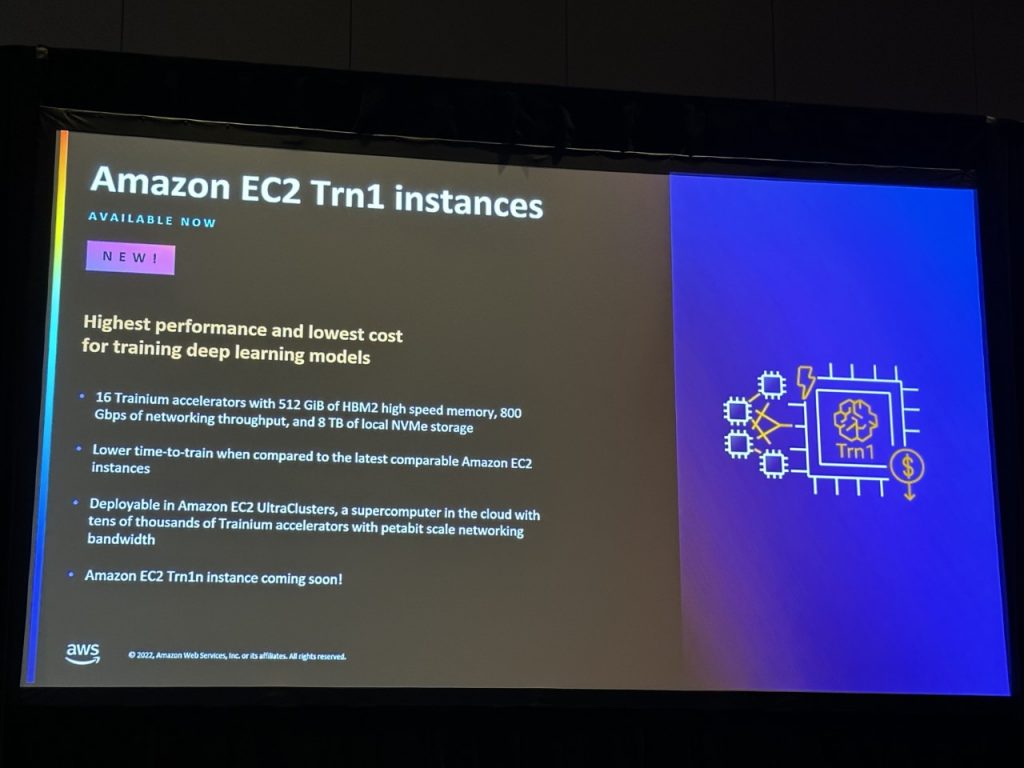

Amazon EC2 Trn1 instances

ディープラーニングモデルのトレーニングにパフォーマンス向上と低コストを実現します。

※近日公開予定とのことです。

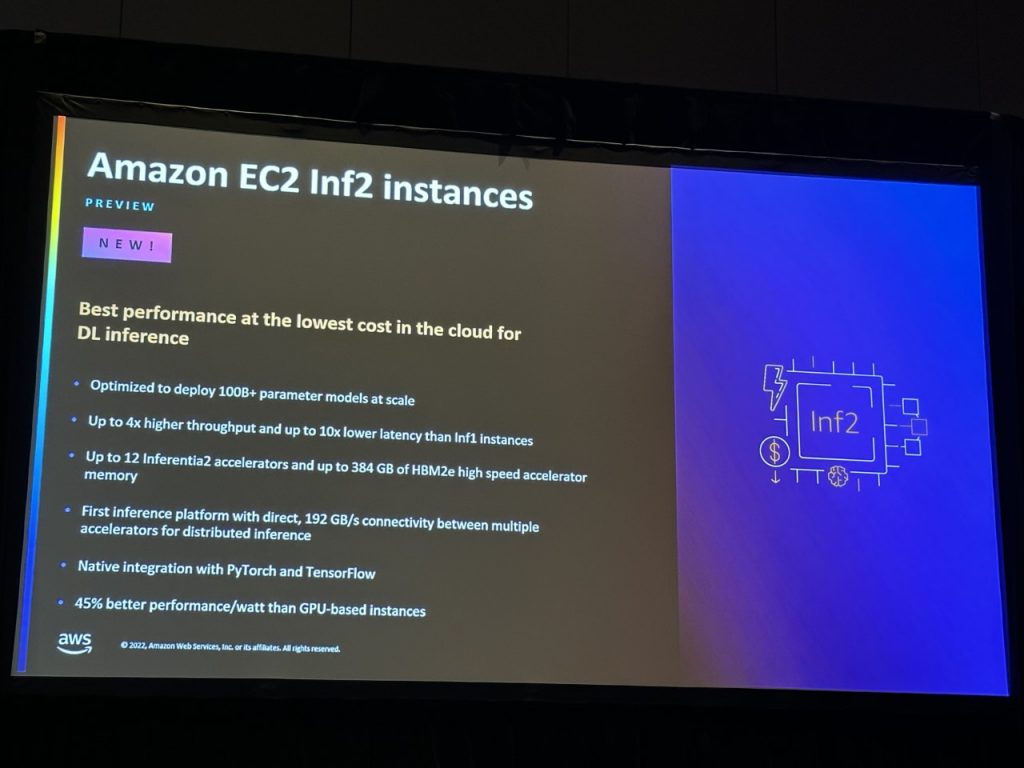

Amazon EC2 Inf2 instances

DL推論において、クラウド上でパフォーマンス向上と低コストを実現します。

感想

これからリリースされる機能もございますが、導入・構築時に少しでもこの記事が参考になれば幸いです。