【Google Cloud Next’24 Las Vegas セッションレポート】Google Cloud環境でLangChainを使用して生成AIアプリケーションをビルド・デプロイしよう

2024.05.08

Googleが主催する世界的なイベント「Google Cloud Next」が、2024年4月9日~4月11日にかけてアメリカのラスベガスにて開催されます。本ブログでは、 Google Cloud Next '24 in Las Vegas に実際に参加したエンジニアから、イベントの様子やKeynote(基調講演)の現地レポートをいち早くお届けします。

第3回目の今回は、4/10(水)09:30~10:15(現地時間)に実施されたHarrison Chase, Thomas Menard, Steren Giannini, Wietse Venemaによるブレイクアウトセッションの内容をお伝えします。

Google Cloud Next とは?

Google Cloud Next とは、Google Cloud のインスピレーション、イノベーション、教育の世界的な展示会です。

意思決定者、開発者、そしてアクセシブルでスケーラブル、かつ社会的責任のあるクラウドに情熱を燃やすすべての人々が一堂に会し、課題、ソリューション、10 倍のアイデア、ゲームを変えるテクノロジーを共有する場です。

Building generative AI apps on Google Cloud with LangChain

今回は、4/10(水)09:30~10:15に開催された「Building generative AI apps on Google Cloud with LangChain」に関する講演をリポートします。

公式サイトによるセッション紹介を日本語訳すると、以下のような内容になります。

“LangChainは、LLMベースのアプリを構築するための最も人気のあるオープンソースのフレームワークです。Google CloudはLangChainアプリをプロダクションにデプロイする最も簡単な場所です。このセッションでは、技術者がCloud Run上のLangChainとCloud SQLのpgvector for vector storageおよびVertex Endpointsを組み合わせて生成AIアプリケーションを作成する方法を学びます。“

引用元:Google Cloud Next Las Vegas ’24公式サイト

登壇者

登壇者はこちらの方です。

| 会社名 | 登壇者 | 役職 |

|---|---|---|

| LangChain | Harrison Chase | CEO & Co-Founder |

| L’Oreal | Thomas Menard | AI Center Of Excellence Manager |

| Google Cloud | Steren Giannini | Group Product Manager |

| Google Cloud | Wietse Venema | Developer Advocate |

内容

Introduction to LangChain

LangChainとは、大規模言語モデル(LLM)アプリケーションの開発を効率的に行うための外部ライブラリ(フレームワーク)です。本来、LLMアプリケーションとは以下のような特性を持ち、フレームワークを使用しないと複雑なものとなってしまいます。

1. 言語モデルがコンテキストのソースに接続し内容を認識する

2. 推論を言語モデルに依存する

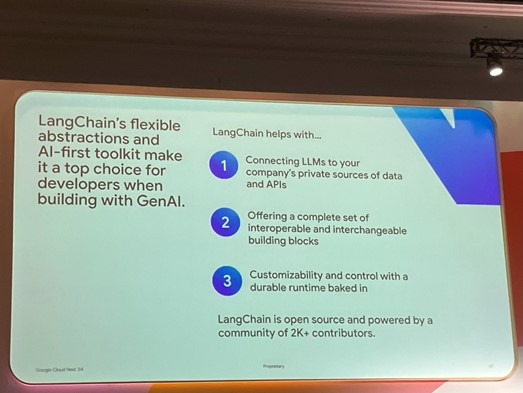

そこでLangChainを導入することにより、開発者にとって以下のような利点があります。

1. 自社のプライベートデータソースやAPIへの接続を容易にする

2. 相互運用可能で交換可能なビルディング・ブロックを提供する

3. 耐久性のあるランタイムを組み込んだカスタマイズ性とコントロール性を実現する

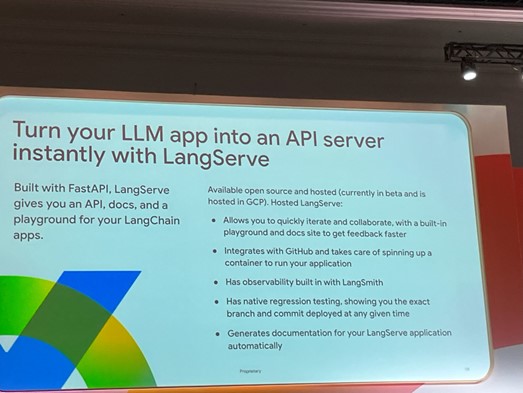

またLangChainを使用したLLMアプリケーションをより簡単にAPI展開する方法として、LangServeというツールが用意されています。FastAPI等との統合がされており、APIドキュメントの生成やネイティブのリグレッションテスト機能、APIのPlayground機能なども提供しています。

Cloud Run for Deploying LangChain Apps

LangServeによりAPI化したLangChainアプリケーションをどのリソースを使用して本番環境に展開するか、 これに対しLangChainの創業者は、Cloud Runが最も簡単で最速の展開を実現できると述べています。

今回のNextLangChainのCloud RunサポートがGAとなりましたが、具体的に、生成AIアプリケーションの構築においてCloud Runは以下のような場面で有用です。

1. Serving & orchestration

Cloud Runではデプロイ後すぐにHTTPSエンドポイントが提供され、非常に高速な自動スケーリング機能が提供されます。 加えてCloud Runには統合機能が組み込まれており、Vertex AI、Cloud SQL、AlloyDB、Cloud CDN、カスタムドメインなどと統合が可能です。

その他使用可能な言語の柔軟性、VPCネットワークへの接続などを踏まえて、セキュアで高可用性な生成AIアプリケーションを提供することができます。

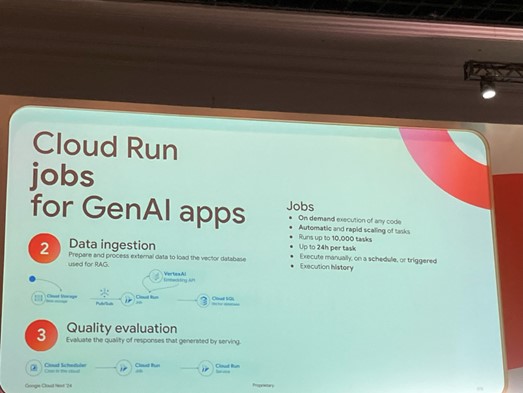

2. Data ingestion

Cloud StorageにデータがインポートするたびにPub/Subを使用してCloud Runジョブをトリガーし、pgvectorを使用したVectorデータベースへの外部データインポート処理を実行します。

3. Quality evaluation

Cloud SchedulerからCloud Runジョブをトリガーして、レスポンスの品質やプロンプトのテストを行います。

Customer story: L’Oreal

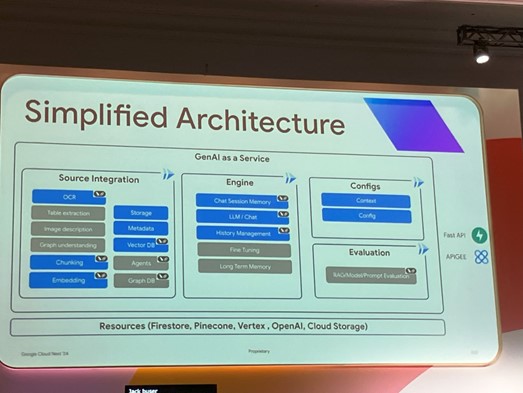

ここでは化粧品会社「L’Oreal」を事例に、LangChainとCloud Runを使用した生成AIアプリケーションの構築方法が紹介されました。

L’Oreal社では「GenAI as a Serviceプラットフォーム」と題して、プロンプト対話・チャット対話・画像生成・検索拡張生成(RAG)の4つの主な機能を持てるよう、ITチームが言語モデルの選択における柔軟性、堅牢性、および法的コンプライアンスを備えた生成AIアプリケーションを簡単に作成およびデプロイできるように宣言型のAPIを提供していました。

感想

KeynoteでもGeminiのアップデートが取り上げられているように、Google Cloud全体で生成AIの利用の需要に応えようという動きがみられている中、生成AIをプロダクトとして実用化させるための方法として、AIの言語モデルおよび実行環境となる言語の汎用性やデータ層といった外部層とアプリケーション層の統合の容易性の観点から、LangChainとCloud Runの採用はかなり魅力的であると感じました。

まとめ

今回はセッション「Building generative AI apps on Google Cloud with LangChain」の内容を紹介しました。

本セッションでは触れられていない、かつプライベートプレビューの機能ではありますが、Cloud Runを使用したアプリケーションのリソース構成を自然言語およびGUI操作で作成できるCloud Run application canvasも合わせると、Cloud Runを使用した生成AIアプリケーションの開発のハードルがかなり下がってきており、生成AI市場のさらなる発展が期待できます。

本記事の内容が皆さんの参考になれば幸いです。