【Google Cloud Next Tokyo ’23】Day2に行ってきました!

2023.11.16

2023年11月15日~16日、コロナウイルス拡大に伴いこれまで延期となっていた、オフラインでのGoogle Cloudのイベントが東京ビッグサイトにて実に4年ぶりに開催されました!

弊社もDiamond SponserとしてJIG-SAW Prime(Google Cloud請求代行)及びシステム運用のご紹介のため出展させていただきました。今回は、Day2に行われた基調講演についてレポートいたします。

DAY2基調講演のレポートです!

DAY2では、生成AIを含む新しいクラウドの使い方について開発従事者のデベロッパーエクスペリエンスをどのように変えていくのかという観点で、今年8月サンフランシスコで行われたGoogle Cloud Next Tokyo ’23にて発表された最新のGoogle Cloudプロダクトとソリューションついてと、異なる業種のビジネスリーダーにより、ビジネス課題をGoogle Cloudでどう解決しているのかについて事例やデモを交えたプレゼンテーションでした。

基調講演の会場では、参加者全員にGoogle Cloud Next Tokyo ’23クッションがプレゼントされました。

広げると座布団のような感じになります。

あとで気がつきましたが、会場の座席がパイプ椅子で硬かったので講演中に利用するためのクッションだったのだと思います。

▼関連レポートのこちらもあわせてご覧ください。

【Google Cloud Next SanFrancisco’23現地レポート】

■DAY2スピーカー

株式会社カプコン 井上真一氏

北國フィナンシャルホールディングス 杖村修司氏

株式会社TBSテレビ 山本善尚氏

株式会社Luup 岡田直道氏

Google Cloud 渕野大輔

Google Cloud 安原稔貴

Google Cloud 寳野雄太

Google Cloud 上床麻衣

Google Cloud 上野由美

Googleの歴史と経験

Googleは今年で25周年。

これまでのソフトウェアイノベーションのアイデアは突然生まれたのではなく、泥臭くこなし、いかに合理的に効率化するかと悩み抜いたところから生まれています。

現在もGoogleの各サービスを支えるデータセンター運用の根幹であるこれらの歴史と経験の上に成り立っているGoogle Cloudのテクノロジーについて、最新アップデートをご紹介していきましょう。

AI-Optimazed Infrastructure

機械学習のトレーニングやサービス化のための推論を行うためのインフラストラクチャ

Google CloudのAIサービスは用途に応じて様々な選択肢を提供しています。

今回のご紹介は、モデルを自分で作成し、サービスとして提供する際に要となるインフラストラクチャのサービスについてです。

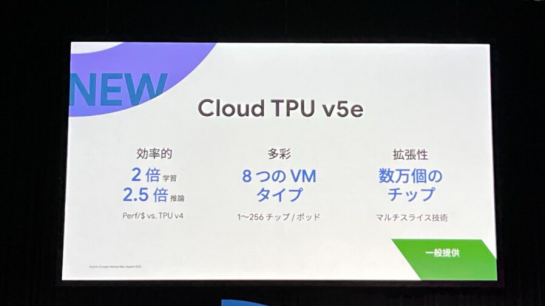

Google Cloud Next’23で発表された、新しいCloud TPU v5について

最新のLLMや生成モデルなど、幅広いAIワークロードに対してスケーラブルで費用体効果の高い学習や推論を行います。

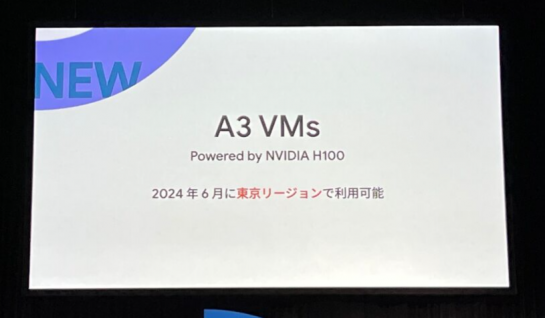

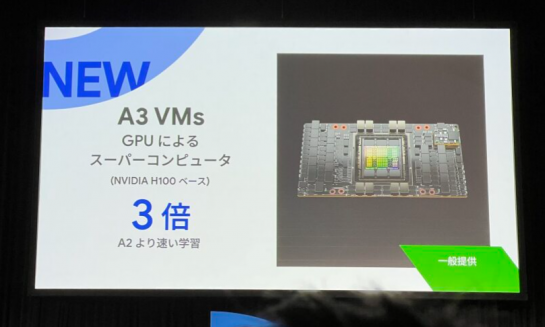

NVIDIAを搭載したA3 VMsは、今日の生成AIや大規模言語モデルなどにおける最も教育の厳しいAIモデルのトレーニングや、サービシングに特化して構築されています。

A3VMは、Googleの独自設計のIntelプロセッシングユニットにより、ハードウェアのチップでネットワーク処理をロードすることで200Gbpsのネットワーク待機を利用可能な初のGPUインスタンスです。

これによりA2VMと比較すると、最大で10倍のネットワーク帯域幅が得られます。

2024年6月に東京リージョンでA3VMsが利用可能となることが発表

データを国外に持ち出したくないというお客様のニーズから、国内で最新モデルのGPUを利用した機械学習の処理を行うことが可能となります。

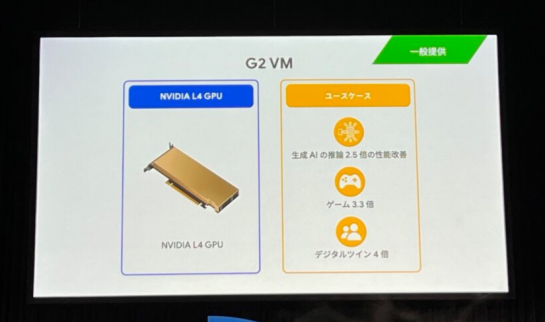

NVIDIA L4 Tensor Core GPUを搭載したG2VMを提供

L4は推論での利用に最適化されており、推論におけるコストパフォーマンスをH100に比べて最大で3倍程度向上させることができます。

モデルの学習が完了しサービスとしての提供を進めている方にとっては最適なGPUとなります。

Transfer Applianceの提供開始について

東京リージョンGAとなっているTransfer Applianceを利用すると、データをアプライアンスにコピーすることで、簡単かつ高速にオンプレミスからクラウドにオフラインでデータを移動させることが可能となります。

Modern and Enterprise Workloads

複雑で高度な要件や運用が求められるワークロードに対して高度な機能を提供

複雑化するエンタープライズアプリケーションに対して最適化された選択肢を提供します。

すでにあらゆる組織がコンテナを利用しています。Gartnerのデータでは、2027年までに世界の組織の90%以上がコンテナ化されたアプリケーションを本番稼働させると予測されており、これは2021年の40%未満から大幅に増加しています。

コンテナ実行環境として、Google Cloudではコンテナ活用の最初の一歩として、最適で簡単に使い始められるCloud Runとマイクロサービス化されたサービスのプラットフォームとして最適なGoogle Kubernetes Engine を提供しています。

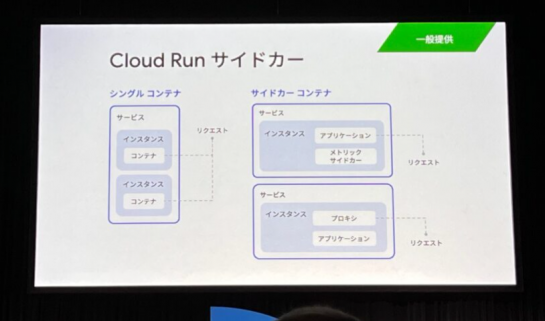

Cloud Runサイドカー対応について

サイドカーコンテナをデプロイできるようになり、オープンソースやサードパーティーの拡張機能をより簡単に利用できるようになりました。

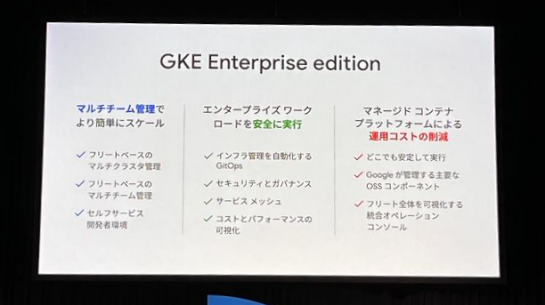

Google Kubernetes Engine(GKE)について

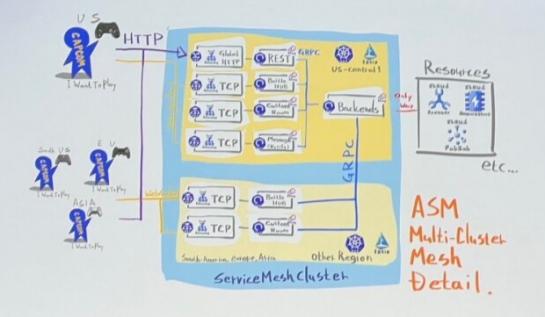

提供するサービスの拡大に伴いマルチリージョンやマルチクラスター構成採用が増えており、その運用負荷に悩まれている方も多いと思います。

この度GAとなったGKE Enteprise Editionでは、複雑化するマルチクラスター管理を簡略化することができます。

複数のチームやクラスターをまとめて管理することができ、セキュリティ対応やマネージドサービス利用により、より少ない運用工数でパワフルなKubernetesエコシステムを利用することが可能となります。

※デモ画面を映して実際の操作方法についてもご紹介がありました。

Reliable and scalable infrastructure

Googleのサービスを支える信頼性の高いスケーラブルなインフラストラクチャ

信頼性が高く、スケーラブルなインフラストラクチャーをサービスの基盤として利用することができます。

VM稼働率SLAの改善

お客様のサービス安定化のための信頼性向上のため、この度全てのVMの可用性SLAを99.5%→99.9%とし、特にSAPなどミッションクリティカルなワークロードで利用されるメモリ最適化VMでは99.95%へ改善していています。

Intelプロセッシングユニット

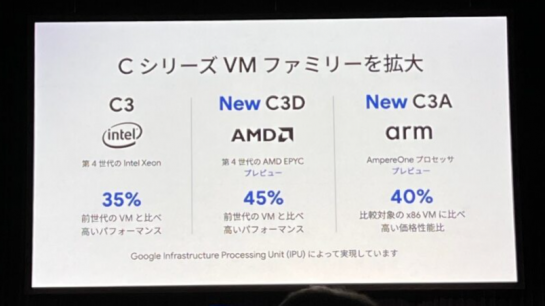

CシリーズのVMファミリーを拡大し、AMD、armをご利用いただけるVMもプレビューとなっており、用途に応じてさらにきめ細やかな選択肢を提供しています。

Titaniumによるオフロード

ストレージの性能向上のためにIntelプロセッシングユニットによるオフロードに加え、TitaniumとしてGoogleのサービスを支えるBorgやColossusのインフラストラクチャーによるオフロードを実現し、VMのリソースの最適化とストレージの性能向上が可能となりました。

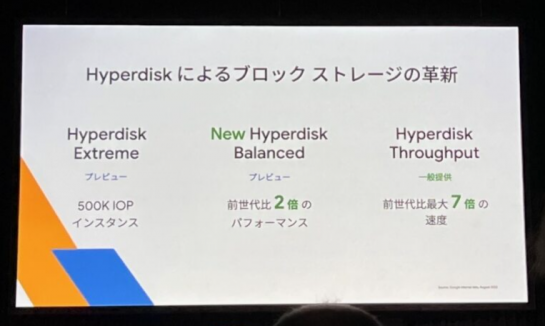

Titaniumによる改善の結果、第3世代のCompute Engine Instanceによって次世代Hyperdiskブロックストレージを利用いただくとパフォーマンスが大幅に向上します。

プレビューで提供しているHyperdisk Balancedでは前世代比で2倍のパフォーマンスが向上、一般提供しているHyperdisk Throughputでは前世代比7倍のパフォーマンスが向上しました。

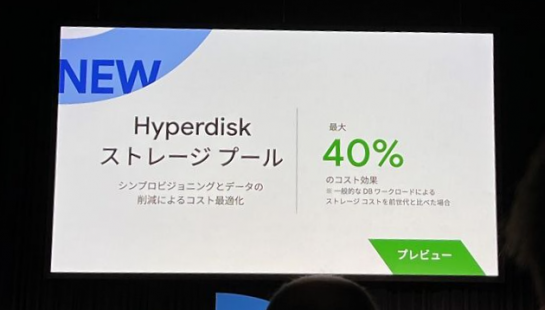

Hyperdiskストレージプール

容量と必要な性能要件によりストレージプールを構成し、ボリュームをそのプールからシンプロビジョニングして切り出せます。

データの圧縮や重複排除などを行うことで、データベースワークロードにおいてストレージのTCOを最大で40%低減できます。

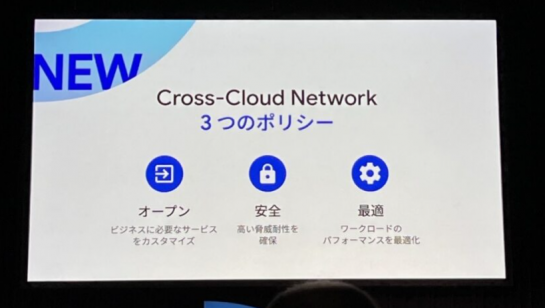

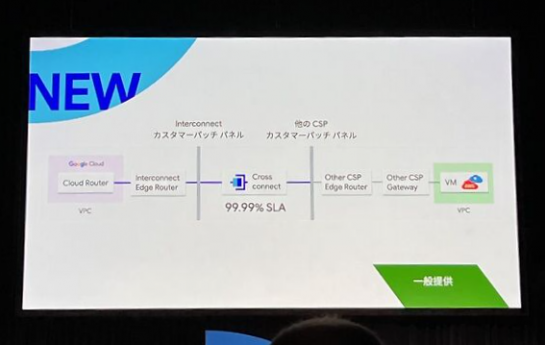

Cross-Cloud Network

複雑なマルチクラウドやハイブリッドクラウド構成が増えており、オンプレミスやクラウド間の接続の品質がワークロードの品質に直結するため特に要件の厳しいワークロードの稼働のためにシンプルで信頼性の高いネットワークが求められています。

Google Cloudとパートナーが提供する既存及び新規のプロダクトで構成されています。

Google Cloudがオンプレや他クラウドの接続のハブになることができます。

以下の3つのポリシーで開発されています。

Cross-Cloud Interconnect

Googleと他のパブリッククラウド間のの専用接続を確立するプロダクトです。Google Cloudの高品質でSLAによって通信品質が保証されたネットワークを利用して高帯域幅の接続が可能となります。現在、サポートされているクラウドは以下となります。

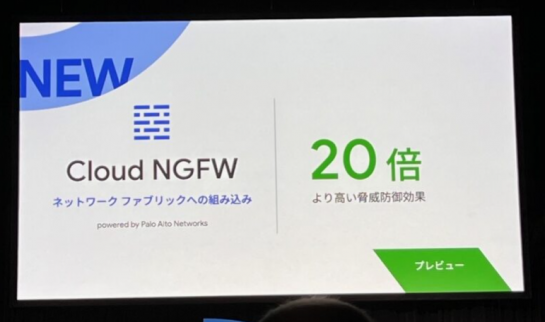

Cloud Next Generation Firewall (Cloud NGFW)

Mandiant および Palo Alto Networksと共同開発した次世代ファイアウォール。

ベンチマークについて検証された高い脅威への防御効果を利用することができます。

またCross-Cloud Networkがトラフィックのハブとなりますが、そこを通るトラフィックのセキュリティ担保をこのプロダクトで行うことができます。

Cross-Cloud NetworkとCloud NGFWとこれに含まるプロダクトを利用することで、複雑化するハイブリッドマルチクラウド構成においても高品質なサービスの提供とセキリティの担保を同時に簡単に実現することが可能です。

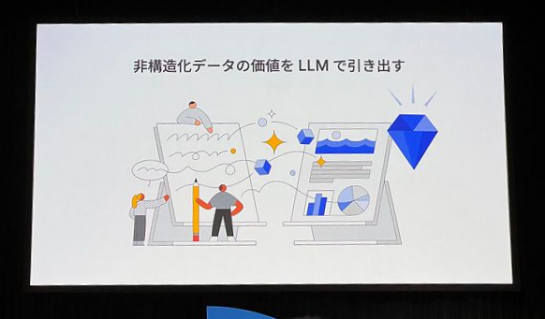

生成AIの活用について

LLMの活用でビジネス価値を生み出す

実際にはなかなかビジネス価値につげることができていなかった画像/音声/ドキュメントなどの非構造化データの進化をLLMによって初めて引き出せるようになりました。

LLMは単独で使うのではなくデータ&AIとして、構造化・非構造化のデータ資産を組み合わせてビジネス価値の進化を引き出すことができます。

※例として、コールセンターの音声データからLLMどのようなビジネス価値が出せるのかデモが紹介されました。

非構造化データをせっかく蓄積しても活用が進まない理由は、コールセンターのデータが大量で、全てを膨大な時間をかけて不満の原因を分類など全体的な傾向をことができない現状に対してLLMの活用が紹介されました。そこでLLMが活用できます。

分析においてPaLMを活用すると、文脈を考慮した分類やサマリを単時間で作成することができます。

このようにLLMは、分類の難しい会話についても内容から判断してデータの全体的な傾向を分かりやすく整理が可能となります。

今まで活用できていなかった非構造化データを構造化データと掛け合わせて分析を行い、洞察を引き出してBIツールで可視化することで意思決定に利用することができます。

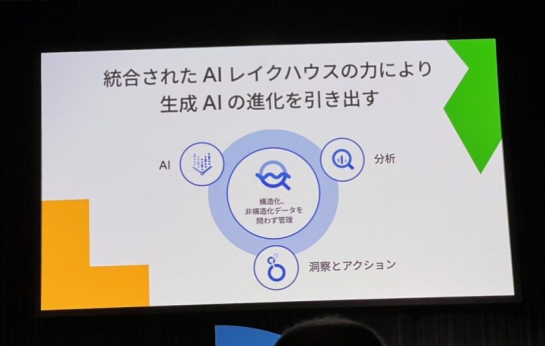

構造化・非構造化を一元的管理し、生成AIを活用して生まれるビジネス価値について言及されていました。

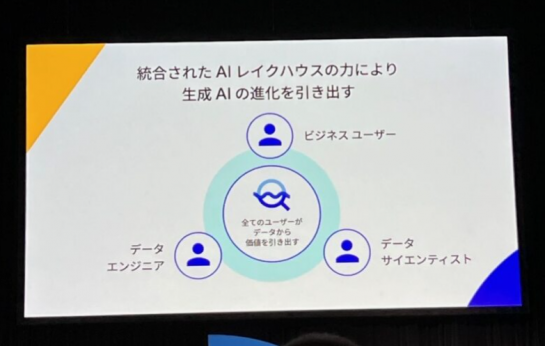

AI Lakehouse

実際にコールセンター事業者がGoogleのLLMとAI Lakehouseを用いてコールセンターの高度化に取り組まれている内容が紹介されました。

BigQueryはデータを構造化・非構造化を問わず、管理/前処理/分析/機械学習まで一気通貫して行うことができるAI Lakehouseです。

このAI Lakehouseがあることで社内外のビジネスユーザー、データエンジニア、データサイエンティストまでがデータの本当の価値を引き出すことができるようになります。

Colab Enterprise

データサイエンティストの皆さんに非常に愛されているのがColablatoryと呼ばれるノートブックソリューション。

セキュリティ、BigQuery連携の機能を高め、新たにColabEnterpriseとして提供開始しました。

Duet AI

ビジネスユーザーやデジタルマーケティングの担当者はDuet AIを利用することで、今までなかなか使いづらかったデータの価値を引き出すことが可能となります。

例えば、同じチームから共有されたSQLの意味を知りたいと思った時にはSQLを入れて解説を求めると意味をデータの意味を含めてビッククエリが回答してくれます。

また、Duet AIインルッカでは、自然言語で見たいデータをチャットで依頼すると、AIが自動的に提案を行いレポートを自動生成してくれます。

このように、LLMを用いることで様々なデータの進化を利用できる機能が実装されています。

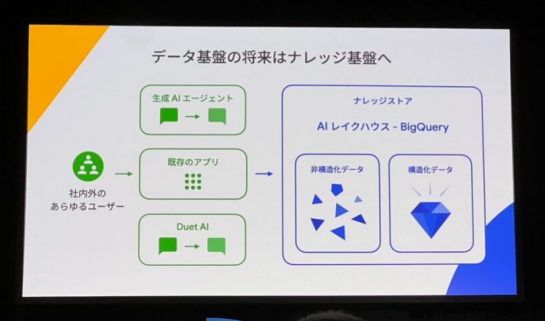

これまでデータ基盤と呼ばれてきたものが非構造化データ・構造化データを合わせて、ナレッジストアとしてAIとデータ分析を統合し一元的に扱えるものとして進化する必要があることに言及されていました。

ここからはGoogle Cloudを活用した企業から事例をご紹介!

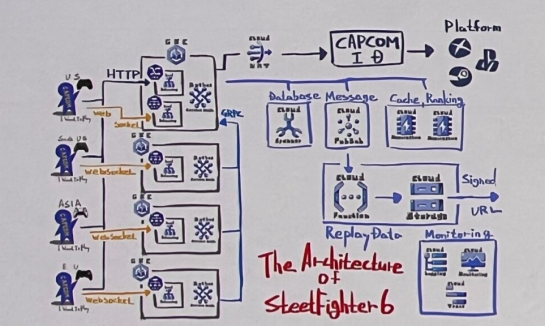

Google Cloudを利用したゲームの事例(株式会社カプコン)

創業40周年の株式会社カプコンから、今年6月に発表したばかりのストリートファイターズ6のGoogle Cloud活用事例が紹介されました。

1987年初代発売から根強いファンを持つ対戦格闘ゲームシリーズですが、ストリートファイターズ6は、少しでも多くの方に手に取っていただけるゲームにしたいと強い思いで立ち上がったプロジェクトでした。

数えきれない挑戦で、発売3日後に100万ユーザを突破、約1か月後には200万本と大きな勢いをもってローンチされました。

これらの多くの機能の裏側では、Google Cloudが活用されています。

1.これまで特定のプラットフォーム同士でしか遊べない制約を取り除いて、PCや色々なゲーム専用機、ハードがどんなものでも世界中の人たちと繋がれるクロスプレイを実現。

Google Cloudの持つ低遅延で障害に強いグローバルネットワーク、プラネットスケールとも言えるインフラは最適な選択肢でした。

世界中で、リアルタイムで、数百万のプレイヤーが正確なランキングに参加するといった、データベースの書き込みが多いゲームならでの厳しい要件も満たしています。

これら多くの機能はマイクロサービスで設計されています。

Google Kubernetes Engine、AnthosServiceMesh(ASM)によって世界中に最適なクラスター構成が柔軟に管理され、スムーズに同期されています。

想定より多くのプレイヤーが集まることによってサーバーが落ちるなど嬉しい悲鳴を上げることなく、ローンチ時のアクセスパイクを無事にさばくことができました。

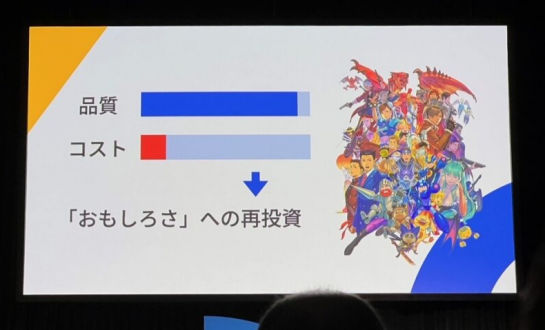

2.開発費(人件費)の削減

昨今のゲーム品質は飛躍的に向上しており、一方で開発費(主に人件費)は大きく膨らんでいましたが、Google Cloudのマネージドサービスを中心としたアーキテクチャによって少人数での開発運用が可能となりました。

また、クリエイターの開発環境や膨大な時間がかかるテストQA環境にAIによる省力化リソースを入れています。

効率化/最適化した技術によって捻出されたリソース・人的な時間は「おもしろさ」へ再投資しています。

エンタープライズ領域における活用例(北国フィナンシャルホールディングス)

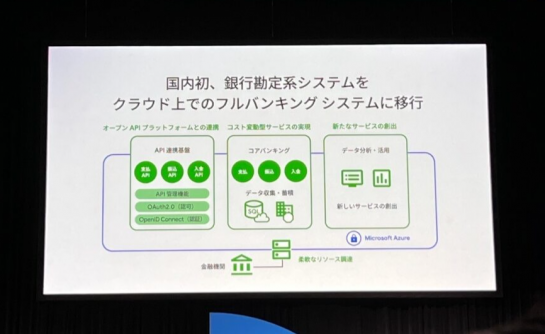

1943年に北陸地域を中心として3つの銀行が合併し、2021年には北国フィナンシャルホールディングスとして生まれ変わった銀行のAzureとGoogle Cloudを活用したハイブリッドクラウドの事例が紹介されました。

今まで以下のIT面のチャレンジを行ってきました。

2021年5月にはこれまでオンプレミスだった勘定系を、パブリッククラウドMicrosoft Azureに上げてフルバンキングシステムを稼働しました。

これは日本で初めての試みです。

次の施策に向けてBaaS機能、更新系API、インターネットバンキングやカード事業の機能拡大、それを支える勘定系のマルチクラウド化に向けて取り組んでいます。

ご存知のように銀行の勘定系は、ミッションクリティカルなシステムです。

オンプレミスと同様に残念ながらクラウドでも一定頻度で障害が起こりますが、その場合は待つしかなく、1つのクラウドだけに依存することはITガバナンス上、プライム市場の企業として許されることではありません。

私たちでコントロールしなければならない。現在の勘定系は1つの巨大なシステムであり小回りが効かない面もあります。

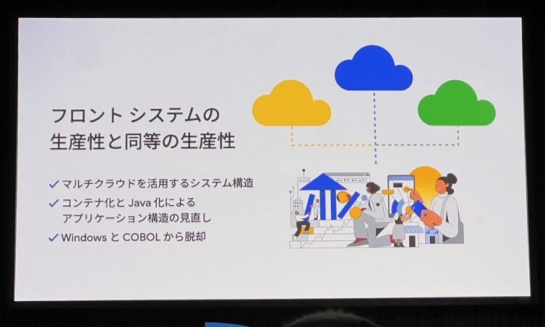

フロントシステムの生産性と同等の生産性を実現させるには、以下が必要でした。

現在の勘定系を大きく進化させ、Google Cloud、Azureを使った勘定系マルチクラウド化とモダナイゼーションアプリケーション構造の見直しを決断しました。

なぜGoogle Cloudを選んだのか

【安定性】

Google Cloudはリージョン単位、全世界規模の大規模障害の発生率が非常に低い。

2つのクラウドを組み合わせることでコントロール可能であり高い可用性のシステムが実現できると思っています。

クラウド間のネットワーク、今年ローンチされたCrossCloudInterconnectはすでに実環境での性能テストにも入っています。

【コンテナ技術における実績】

Googleの先駆け、リーダーシップは他と比べるべくもなく、特に大規模しかも効率的なコンテナ運用は、銀行の勘定系には必要です。

また、GKEの採用を検討しています。Googleの堅牢な基盤を活用することができることはとても魅力的です。

【カルチャー面、DNAの親和性】

Googleマインドの研修を受けて社内は活性化し、思った以上に心理的安全性も強化されました。

マルチクラウド感情系とモダナイゼーションは絶対にやり遂げることができる素晴らしいチャレンジだと思っています。

Google Workspace活用例(TBSテレビ)

ファイル共有機能から始まったG suite(現:GoogleWorkspace)の導入と現在のGoogle Workspace活用に関する事例が紹介されました。

ファイル共有について

2015年にドラマや海外番組販売分野でのメディアによる素材の受け渡しについて、大容量のファイル共有を解決するソリューションとして一部のユーザーからGoogle Appsの利用が始まり、その後、2018年に社内の業務フロー改善を目的としてG Suiteの導入が始まりました。

当時は紙文化での業務フローが数多く残っており、データはオンプレのサーバーに保存、クラウドよりオンプレの方が安全という意識でしたが、データをクラウドに保存するといったことやドキュメントやスプレッドシート等を共同編集することにより業務効率を大幅に上げられるのではと考え、グループウェアの導入を決定しました。

また、2019年型コロナウイルスにより、テレワークによるMeetの活用、ドキュメントやスプレッドシートでの共同編集作業などG Suite活用によって業務効率化が一気に進みました。

TBSの系列局のネットワーク局であるJNNでもGoogle Workspaceの導入が進んでいます。セキュリティが厳しい局でも共有ドライブによるファイル共有がスムーズに行えるようになりました。

AppSheetの活用

情報システム設備は数百システム存在します。各部署やスタッフの要望に答えて個別にスクラッチ開発されてきたシステムがほとんどです。

このようなシステムは保守費用や開発コストが高い、業務内容の変化に簡単に追従できないといった問題も抱えています。

各部のワーフフローにの変化に柔軟に対応できる手法がAppSheetによるノーコード開発だと思います。

例えば、今年の新人研修でGoogle CloudにてAppSheetのハンズオンを行っていただき、自ら数個のアプリをすぐ開発する新人が現れました。

また、7月にはAppSheetハッカソンを開催し、幅広い年代幅広い役職の方に参加いただきました。数多くの課題が溢れ、TBSとして今取り組むべき課題というのがはっきりした良いイベントになりました。

その後行われたアプリ開発でも、番組のロケで行った情報を共有するとといった即戦力のアプリも開発されました。

DXを推進するためTBSでは新たな部署も立ち上げ、AppSheetにより開発されたアプリ第1号がローンチされました。(制作現場スタッフを管理するアプリ)

今後のDuet AIについて

現在トライアルで利用中ですが、ドキュメントやスプレッドシート、スライドと連動した生成機能に期待しています。

これまで多くの時間を費やしてきた事務作業が大きく軽減され、業務効率が上がることが期待されます。

TBSでは2030年に向けてコンテンツ企業を目指して改革を行っており、Duet AIによって創出された時間をコンテンツ制作などクリエイティブな作業に費やせることが非常に大切だと考えています。

Duet AIリリースにおいては、第一にセキュリティや情報管理に関して安全に使用できることを期待しています。

グローバルなコンテンツ企業を目指していますので、英語のみならず様々な言語に対してシームレスな業務が行えるような環境をGoogleに実現してもらいたいと考えています。

2024年中に日本語サポート開始が発表されました!

スタートアップ企業のGoogle Cloud導入事例(株式会社Luup)

電動キックボードや電動アシスト自転車などのモビリティを提供しているサービス「LUUP」の開発にGoogle Cloudを導入した事例が紹介されました。

「LUUP」はアプリからレンタルして、開錠/施錠の制御を行い、その車両が置かれているスポットのポートからまた別のポートへ自由に移動することができるサービスです。

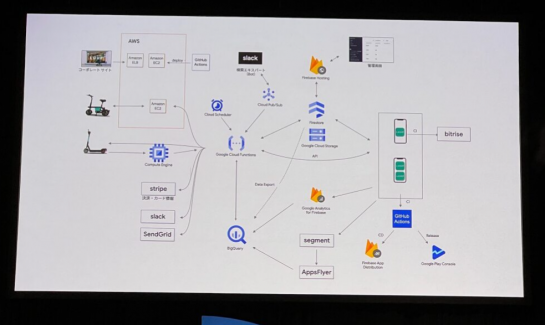

立ち上げ期の活用について

クラウドサービスに求めるものは可用性と安定性とスケーラビリティです。

ビジネススタートアップが新しいビジネスを始める際には、少ないアセットを持ってスモールスケールでサービスを立ち上げられる環境が必要です。

クラウドサービスをアプリケーションのインフラに据えることが、今日ITスタートアップではスタンダードな選択になってきていますが、私たちはさらに開発の速度を求めるため当時立ち上げ期の時点で十分に実用に耐えられそうであることや、今後もサービスとしての広がりを確信し、Firebaseを技術選定しました。

▼創業期から2年前後までの初期のLUUPのアーキテクチャ

モバイルアプリのバックエンドのAPIには、Cloud Functionsを採用しサーバーレスアーキテクチャを構築しています。

データベースにもNoSQLデータベースのFirebaseを全面的に採用しました。

社内向けに管理しているWebアプリもFirebaseホスティングを利用することでインフラの構成管理を気にせずスピーディにデプロイすることができました。

また、Google Cloudを使うことでその後の事業展開においてもスムーズな拡大ができています。

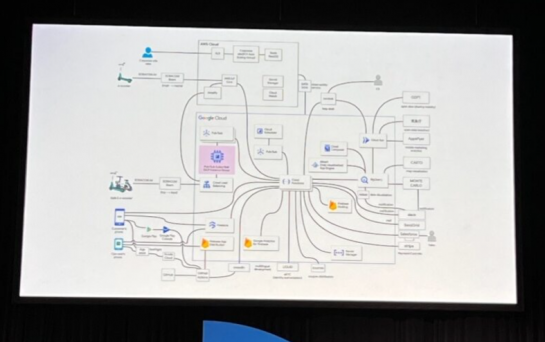

▼現在のLUUPのアーキテクチャ

APIの種類が増え外部サービス含めて非常に接続するサービスの数が多くなっている現在でも、ベースの構成はCloud FunctionsやCloud Firestoreを中心とした近いものを維持しています。

データ分析基盤もBigQueryをベースにクラウドコンポーザーやCloud Runなど複数のサービスを採用したデータパイプラインを構築しています。

これらの技術選定においても、Google Cloudのマネージドサービスを連結させてアーキテクチャを設計することに恩恵を感じています。

データ分析について

シェアリングサービスを支えるデータ活用の重要性について

1.1日の利用者数や利用時間などのユーザー指標を分析

2.物理的なエリア展開計画へのフィードバック

3.シェアリングサービスを維持するためのオペレーション業務

データアクセシビリティ向上のの活動を進めておりエンジニアだけでなく、様々な職種のメンバーがBigQueryや他のBIツールを使って直接クエリを書くことで分析を行っています。

また、Google Workspaceを採用しており、クラウド基盤と合わせて1つの社内IT基盤として利用できているがゆえにアカウント管理や権限の管理がしやすいという点にもメリットを感じています。

Google Maps Platformを利用しているため、Google Cloudサービスに構成が一本化されていることの恩恵があります。

感想

DAY2基調講演は生成AI活用~事例発表の4社と、ボリューム満点でした。

会場は満席で隣席ととても近く(ギューギューでした)、終了後には若干の疲労感がありましたが、とても有意義な充実した内容で、今後生成AIを取り入れて業務効率化を図りたいと思いました。

最後に、次回のGoogle Next Tokyo’24は2024年8月開催と発表がありました。

来年もどのようなイノベーションがあるのか、Google Cloudの新たな進化が楽しみです!